********

******** ********

********个人介绍

掌握Java核心,具有有良好的编码能力,参与过多个项目的重构与核心代码编写

掌握并发编程、项目中多个核心模块采用并发实现

掌握JVM相关知识,了解常见垃圾回收算法、垃圾回收器

掌握常见的设计模式且在应用中实际应用过

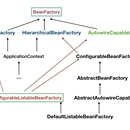

掌握Spring、Springboot、mybatis、xxl-job等常规框架,且对其底层较为了解

掌握Mysql、Oracle、PG等常规关系型数据库

掌握TiDB分布式新式关系型数据库

掌握Redis,熟练使用其分布式锁,解决应用中的常见问题

掌握

Clickhouse列式存储数据库,熟悉其MergeTree、Kafka、Hdfs等引擎

熟练使用商业版Doris列式存储数据库,其多表关联性能大大优于Clickhouse

熟练使用Kafka、RocketMq等消息队列中间件,解决不同场景下的异步消息问题

熟练使用HDFS的Java接口应用

熟练使用大数据Hadoop生态圈,如Hbase、Sqoop、Oozie、Hive、Hdfs、Presto、

Druid等技术

熟悉实时流处理框架Flink,参与部门实数仓搭建

熟练使用Nodejs、Vue、Webpack、Vue-cli3、Iview、AntDesign等进行前端的构

建、打包、开发等

具体工作:

1、参与组内项目重构

2、参与项目框架搭建,代码开发规范制定

3、参与核心模块功能的设计与实现,是项目最核心源码编写者之一

4、负责版本发布、验收,Review团队成员业务代码

5、指导开发人员进行开发,帮助解决开发中遇到的技术问题

6、协助业务进行其他事项

工作经历

2018-10-01 -2021-07-01中国平安人寿保险股份有限公司java资深开发工程师

1、参与组内项目重构 2、参与项目框架搭建,代码开发规范制定 3、参与核心模块功能的设计与实现,是项目最核心源码编写者之一 4、负责版本发布、验收,Review团队成员业务代码 5、指导开发人员进行开发,帮助解决开发中遇到的技术问题 6、协助业务进行其他事项

2015-04-02 -2018-10-01上海爱道实业有限公司高级后端工程师

1、SSM单应用项目框架搭建 2、常规应用开发 3、基于BPM产品的二次开发 4、主要是参与日常需求开发 5领导交代的其他事项

教育经历

2010-09-01 - 2014-07-01兰州财经大学计算机科学与技术本科

暂无

技能

项目描述: 该项目主要为公司研发的实时线索系统,支持高并发量的用户数据请求。并经过一系列 内部处理后发送给坐席系统,用于坐席系统的后续跟进 工作内容: 1.配合架构师进行框架的搭建、项目基本公共服务的接入 2.实时数据进入、流转、除黑、除重等核心功能模块的设计与开发,核心代码编写 3.对异常数据的捕获、补跑等功能的设计,及接口规范制定 4.其他常规功能开发

项目描述: 一个基于实时计算、统一服务API、报表于一体的数据化服务平台,旨在为业务提供高 性能的、高稳定的、跨多数据源的数据治理、服务、展示平台 工作内容: 1. 调研市场当前的数仓搭建方案,制定符合我们部门的数仓搭建方法 2. 经过反复调研、POC,决定使用基于Flink流、FlinkSql、Kafka、TiDB、D一体化 的实时数仓方案 3. 主要负责搭建基于公司微服务框架ARK的统一服务API平台与报表平台,后台、 前台框架搭建、流水线部署、公司公共服务接入等 4. 统一服务API平台中实现项目自定义添加数据源、 可基于数据源的配置化API接口, 目前支持的数据源有MySql、 Oracle、 Druid、 PG、 Hive、 Presto、 Doris、 Hbase、 TiDB等 5. 报表平台目前主要实现了报表的页面可配置化、定期执行、缓存等功能,可实现业务 报表的快速上线运行 6. 对于现有的离线hive数据与实时关系型数据库无法聚合查询的问题, 目前使用的是 Presto进行跨库查询,目前正在POCDoris方案,希望其能替代Hadoop组件复 杂的问题

项目描述: 该项目主要为公司研发用于总部人员与分中心人员, ,其核心功能为根据大数据平台提 供的用户的多维标签,对用户进行分群、分类营销等功能 工作内容: 1、重构的前期调研、老系统功能梳理 2、项目框架搭,前后端分离的分布式应用,主要负责前端框架的搭建,后台公共服 务接入 3、参与用户分群营销核心功能用户分群营销模块的设计,技术选型,首套方案采用 Sqoop、Oozie、Hive、Druid、Quartz 4、编写用户分群营销核心代码,整套流程开发 5、指导其他开发进行配套模块的开发并进行联调 6、为解决在JOB多、调度频繁情况下quartz死锁情况,废弃原有的quartz, 引入xxl-job,为适配本项目,修改权限校验、异常机制等部分源码 7、为解决首套方案性能无法满足业务,研究Clickhouse列式存储数据库,并引入项目中,目前取得了不错的性能提升 8、为解决公司原有KETTLE同步工具发版不够灵活、学习成本高等问题,引入 DataX数据同步方案,修改其源码,增加异步回调机制,以满足数据同步快速上线,目 前相关数据同步基本已全部迁移基于DataX,兼容HDFS引擎等的核心同步模块 9、公司原则是要脱O,在这个基调下,引入TiDB数据库,重构关联系统下发等 功能,目前取得了不错的效果,实现在本年底由一个重Package的系统到脱O系统的 跨越