********

******** ********

********个人介绍

1. 熟练掌握Scala、Java语言 ,Linux常用命令

2. 了解HDFS,YARN,Zookeeper,Spark,Flink,Kafka,HBASE等运行原理

3. MySQL,Hive,HBase,MongoDB,Clickhouse,ElasticSerch的基本使用

4. 掌握Flume,Filebeat,Logstash数据采集工具

5. 熟练使用sparkcore,sparksql编写离线任务

6. 熟练使用sparkstreaming,flinkSQL编写流处理任务

7. 熟练操作Kafka与各个组件的整合使用

8. 了解Prosto,OLAP联机分析处理原理及应用场景

9. 熟练使用Dbus+Wormhole可视化实时同步数据

10. 了解solr并具备简单的权重设计能力

工作经历

2018-06-29 -至今恒流大数据开发

1. 熟练掌握Scala、Java语言 ,Linux常用命令 2. 了解HDFS,YARN,Zookeeper,Spark,Flink,Kafka,HBASE等运行原理 3. MySQL,Hive,HBase,MongoDB,Clickhouse,ElasticSerch的基本使用 4. 掌握Flume,Filebeat,Logstash数据采集工具 5. 熟练使用sparkcore,sparksql编写离线任务 6. 熟练使用sparkstreaming,flinkSQL编写流处理任务 7. 熟练操作Kafka与各个组件的整合使用 8. 了解Prosto,OLAP联机分析处理原理及应用场景 9. 熟练使用Dbus+Wormhole可视化实时同步数据 10. 了解solr并具备简单的权重设计能力

教育经历

2018-01-10 - 2020-07-10北京电子科技职业学院计算机应用技术专科

成人自考大专学历,学习时间和上班时间不冲突

技能

该项目背景产生于公司面对大量数据查询mysql延迟较高的问题下研发得出,主要用于展示公司的多维度订单分析情 况,该项目主要负责数据源的分析,数据的转化整理,数据的清洗和归类以及相关指标的计算。最终以网页的形式展示多 维度的订单分析报表,具体展示的有订单GMV,各地区销售情况,转化率,商品品类销售情况,商家活动欢迎度,车主活 跃度等

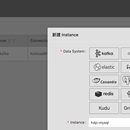

大家普遍使用的都是编写spark,flink代码的方式去完成公司一些指标的计算,为了降低开发成本,大数据中心领导提出界面操作etl以及实时任务的开发,所以选择dbus+wormhole开源项目二次开发,实现界面化操作实时任务,这两个组件集成基本可以满足公司的一些实时同步或者实时计算任务功能。