********

******** ********

********个人介绍

毕业于河南科技大学,熟练掌握typescript及编译器,webpack,gulp,vite,scss等工具,熟悉typescript编译器编译原理,熟练使用angular/vue/react三大框架,后端熟练使用nestjs/koa/express/mongodb/mysql/postgres/redis/mq等

工作经历

2014-12-27 -2019-05-01杭州米波网络科技有限责任公司法人

负责小程序、公众号、小游戏、办公ERP、pc建站等多业务场景开发,负责整个软件周期的开发及准备工作,从前期客户沟通,产品原型制作,到前端页面开发,后端接口开发,数据库设计,模块化分,部署上线,优化升级,备份迁移等

教育经历

2010-01-01 - 2012-06-01河南科技大学包装工程本科

肄业,无毕业证,大三退学创业,创建科大淘二手交易市场,河南科技大学BBS社区,大学生创业联盟主席

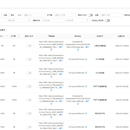

技能

跑腿一定是新零售、社区团购、各种线下营销服务较直接的第一入口,也是维持用户忠诚度很靠谱的途径。 模块基于共享经济思维,采用众包模式,追求一种高效、快捷的操作体验。在响应时间、取送速度等诸多维度提升服务体验,实现同城即时专人直送的专业跑腿模式。客户无论在城市的什么位置,需要递送何种物品,都可以发起服务请求,基于 LBS 技术,系统会将订单推送到客户周围的骑手*上,骑手就近进行抢单,并以很快的效率完成服务,全程由唯一的骑手专门完成,更快速、更便捷、更安全,客单价高、保证盈利稳扎稳打的拓展市场才能活得下去。

1. 某视频平台视频资源自动爬取 2. 集群化多节点爬取,前端直播及播放器解码器制作 3. 监控直播结束后,上传到制定存储位置,生成永久回放连接 4. 存储使用情况监控,实时预警 5. 前端小程序开发制作(包含会员登录预注册,会员续费与充值,视频分类及视频回放观看)

一、预打标签 对发帖ID进行 央级主流媒体、地方级主流媒体、市场化媒体、自媒体的标注 二、数据处理需求 2.1数据库整体需求 (1)数据输出格式:SQL 和 csv (2)为了高效查询,需要将5个层级的数据关联 (可以使用关联表,在话题层级需要关联事件ID;在帖子层级需要关联话题ID;在评论层级需要关联帖子ID;在子评论层级需要关联评论ID) 2.2文本处理需求【帖子文本、评论文本、子评论文本】 (1)统计文本长度 (2)文本词性标注统计(具体为名词、动词、形容词、副词词数统计) (3)文本情感词分类统计(具体为 正面、中立、负面词数统计,更多累;或已实现的?类分类) (4)提取文本的主情感(目前可实现的情感分类几类?正面、中立、负面) (5)计算文本的可读性(一般使用何种方法?fog指标?)