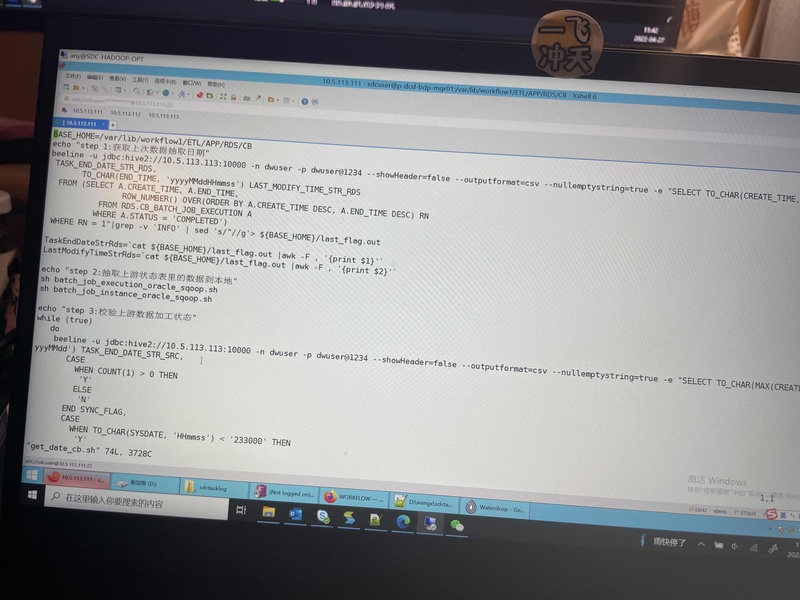

Nginx+MySql+kafka+Flink+HBase+Pheonix+MaxWell+FlinkCDC+Redis+ClickHouse+Prometheus+Gran ada+Sugar项目描述:本项目基于Flink技术开发的大数据统计分析平台,目的是通过对聚美购物网站以及APP的各种用户行为数据 进行统计分析,用分析的数据辅助产品经理、数据分析师以及管理人员分析现有产品的情况,并根据用户行为分析结果 持续改进产品的设计,以及调整公司的战略和业务。最终达到用大数据技术来帮助提升公司的业绩、营业额以及市场 占有率的目标。xxcen9du202201112001个人职责: 主要负责对业务交互数据和用户行为数据进行分析。主要实现的指标包括: 1. 最近一个小时的交易金额2. 统计一天内的浏览下单转化率3. 统计用户跳出率4. 统计分时访问流量显示5. 关键词热度排行技术描述:1. 通过MaxWell从MySql中抓取对应的数据表的实时新增变化数据推送到kafka2. 通过Nginx日志采集将用户行为数据推送到kafka3. 利用Flink侧输出流将日志数据进行分流,分为启动,事件,曝光,页面,错误五个主题4. 利用FlinkCDC读取MySql配置表(制定了哪些表要去哪里的规则),转化为广播流并与业务流进行connect,进 行动态分流5. 利用Phoenix在HBase中建立维度数据表,并创建二级索引,提升查询效率6. 通过Flink的intervalJoin将事实数据进行双流join形成宽表,事实数据与维度数据进行关联时,通过Redis来实现 旁路缓存机制,并通过实现异步IO提升查询维表的效率7. 根据EventTime合理设置WaterMark实时展示登陆、订单和支付数据明细 8. 使用FlinkCEP编程实现对用户跳出明细的过滤9. 确保缓存数据一致性,更新HBase时主动将Redis中的对应数据删除,并且Redis设置过期时间,避免冷数据长期占 用缓存,开启Flink检查点Exactly-Once,配合Flink Kafka Producer两阶段提交以及Phoenix事务机制,确保数据 不丢失不重复。10. 通过union拉宽表,分组开窗聚合,关联维度表补充维度数据,将结果写入ClickHouse中 11. 从ClickHouse读取数据发布接口,对接可视化模块

声明:本文仅代表作者观点,不代表本站立场。如果侵犯到您的合法权益,请联系我们删除侵权资源!如果遇到资源链接失效,请您通过评论或工单的方式通知管理员。未经允许,不得转载,本站所有资源文章禁止商业使用运营!

下载安装【程序员客栈】APP

实时对接需求、及时收发消息、丰富的开放项目需求、随时随地查看项目状态

评论