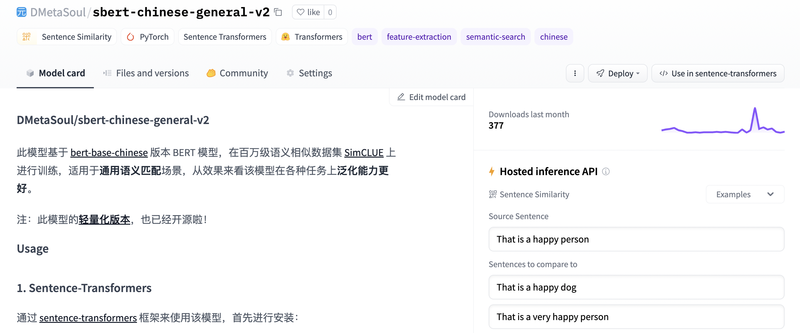

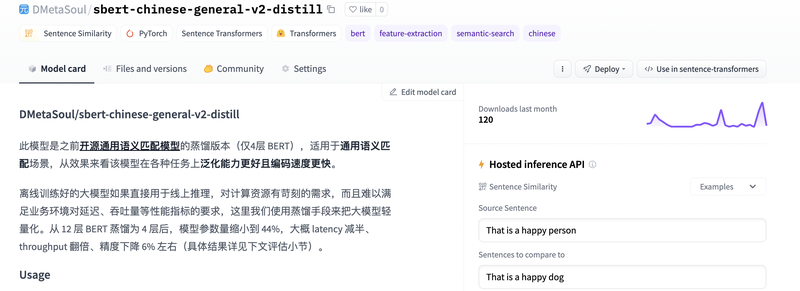

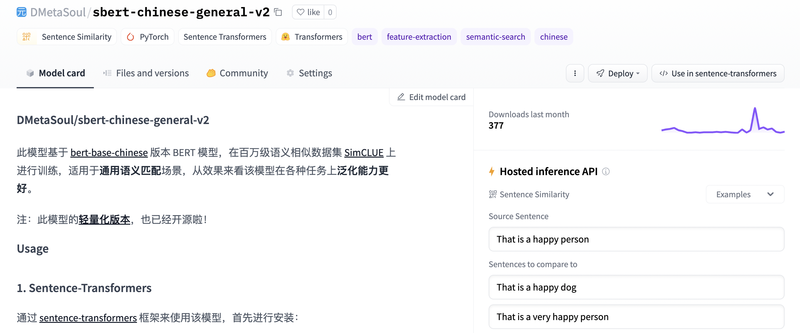

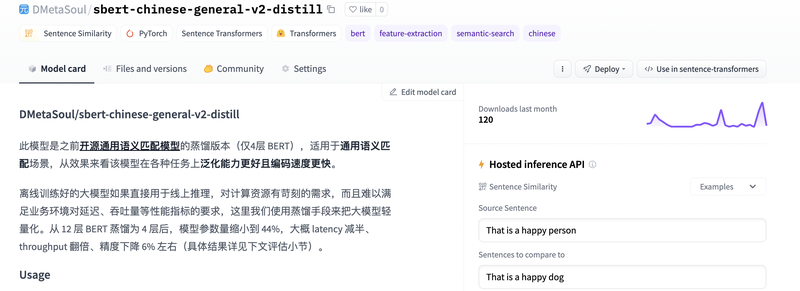

1. 项目概述当前自然语言处理领域的预训练技术较为成熟,当在真实的业务场景下面临的问题却较为碎片化,需要算法开发人员进行专门化的定制优化,本项目的目的在于构建一套可以自适应多领域的预训练平台,这样像金融、医疗等领域的开发人员就能便捷的使用到预训练的前沿技术红利。目前已经开源的领域预训练模型有:(1)通用领域的轻量化模型:https://huggingface.co/DMetaSoul/sbert-chinese-general-v2(2)对话领域模型:https://huggingface.co/DMetaSoul/sbert-chinese-dtm-domain-v1(3)金融领域模型:https://huggingface.co/DMetaSoul/sbert-chinese-qmc-finance-v12. 整体架构预训练语言模型通过在大规模文本上进行预训练,可以作为下游自然语言处理任务的模型参数或者模型输入以提高模型的整体性能。不过开源的通用预训练模型在特定领域/任务上可能效果不佳,这可能有多方面因素导致,比如通用和特定领域语料分布差异大、领域存在专有词汇、特定领域/任务存在低资源问题等。 业界已经验证了在特定领域/任务上继续无监督预训练,对最终特定任务效果提升是有帮助的。为此我们也按照这个思路迭代,希望可以在业界常见领域/任务上预训练出相应的大模型,让大模型可以更好在垂类问题上落地。自然语言处理(NLP)预训练模型在多领域的适配平台,主要包括以下几个部分:(1)多领域经典监督文本分类数据集作为benchmark(2)多领域语料数据的收集和整理(含新闻、金融、医疗等)(3)基于领域语料进行切词器(tokenizer)的训练(4)基于领域语料进行领域预训练模型(pre-training)的训练(5)对领域适配的预训练模型进行自动化评估 3. 核心贡献收集开源语料数据,利用先进的 NLP 训练技术和预训练模型在特定领域数据上进行迁移学习,最终产出通用、对话、金融、新闻等专用领域模型 10+,并且模型已经开源到 huggingface 社区。4. 难点和挑战领域模型的训练主要挑战有以下几点:- 领域数据缺少,针对这个问题,我们进行了广泛的调研从网络上收集了大量的专用领域数据,规模达到 TB 级别- 预训练模型大,对计算资源要求高,借助强大的分布式机器学习训练平台以及对模型算法的切分优化等技术,使得大模型可以被快速的训练

声明:本文仅代表作者观点,不代表本站立场。如果侵犯到您的合法权益,请联系我们删除侵权资源!如果遇到资源链接失效,请您通过评论或工单的方式通知管理员。未经允许,不得转载,本站所有资源文章禁止商业使用运营!

下载安装【程序员客栈】APP

实时对接需求、及时收发消息、丰富的开放项目需求、随时随地查看项目状态

评论