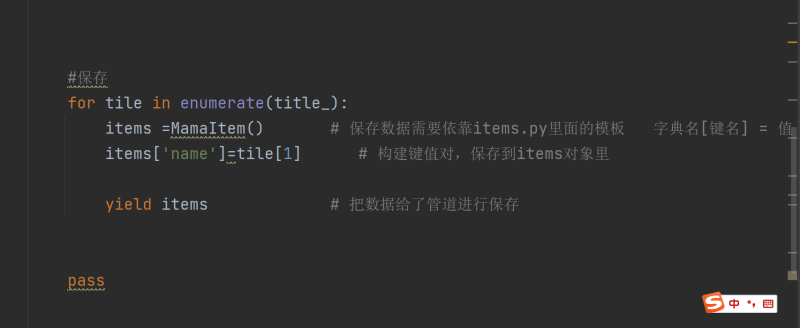

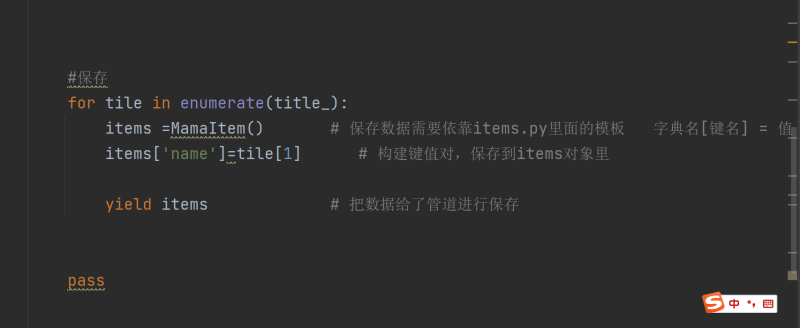

首先爬取首页后通过xpath匹配每个的信息块的span后构建请求,并通过scrapy.Request发送请求,用xpath匹配需要的信息。同时循环创建下一页请求的form表单,通过scrapy.FormRequest发送POST请求。所有爬取的信息缓存到redis数据库中,最后通过编写python脚本将redis数据库中数据读取出来加入mysql数据库。声明:本文仅代表作者观点,不代表本站立场。如果侵犯到您的合法权益,请联系我们删除侵权资源!如果遇到资源链接失效,请您通过评论或工单的方式通知管理员。未经允许,不得转载,本站所有资源文章禁止商业使用运营!

下载安装【程序员客栈】APP

实时对接需求、及时收发消息、丰富的开放项目需求、随时随地查看项目状态

评论