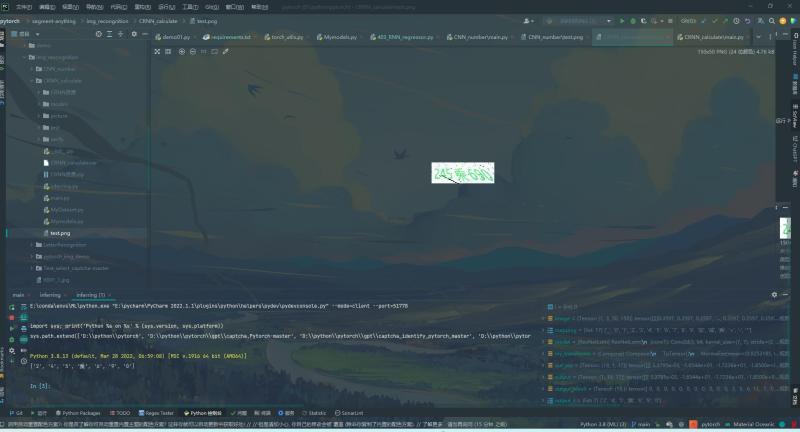

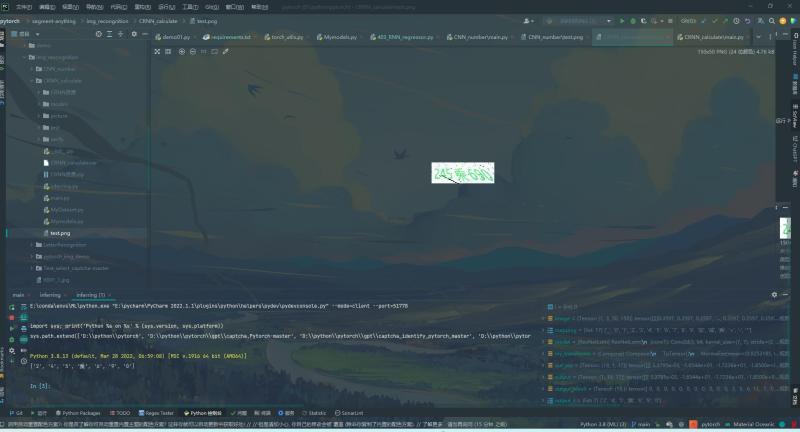

通过卷积神经网络和循环神经网络实现验证码识别,对于训练神经网络,batch size 的大小会对模型的训练产生影响,不是越大越好。这是因为 batch size 的大小影响到模型参数的更新方式和更新频率。较大的 batch size 可以在每个 epoch 内处理更多的样本,从而使梯度下降更新更加稳定,减少了训练时的波动。此外,较大的 batch size 还可以利用 GPU 并行计算的能力,从而加快训练速度。但是,较大的 batch size 也会导致一些问题。首先,较大的 batch size 可能会导致模型过拟合训练集,因为模型可能会过度依赖于训练集中的噪声和特定样本的特征。其次,较大的 batch size 可能会降低模型的泛化能力,因为模型更容易学习到训练集的特殊性质而忽略其他可能的特征。因此,在实践中,选择合适的 batch size 是非常重要的。通常情况下,建议选择较小的 batch size,例如 32、64 或 128,同时可以利用优化器的动量等技术来提高训练效果。如果内存和计算资源允许,也可以适当增大 batch size。但需要注意,不同的模型和数据集可能需要不同的 batch size。由于我们这里的数据集只有3000左右,我们就选择较小的batch_size即可,使用8声明:本文仅代表作者观点,不代表本站立场。如果侵犯到您的合法权益,请联系我们删除侵权资源!如果遇到资源链接失效,请您通过评论或工单的方式通知管理员。未经允许,不得转载,本站所有资源文章禁止商业使用运营!

下载安装【程序员客栈】APP

实时对接需求、及时收发消息、丰富的开放项目需求、随时随地查看项目状态

评论