********

******** ********

********个人介绍

简介:2018年以linux运维工程师的身份进入IT 行业,现从事网络安全及网络故障分析工作,参加过三次国家组织的红蓝对抗,工作中经常需要设计和开发各类脚本工具。用到最多的脚本主要是excel 处理脚本、页面爬虫脚本。此外,自主设计过python 爬虫程序,可实现对90%的网站任何有规律内容进行爬取。

工作经历

2019-10-01 -至今北京深空智联科技有限公司网络分析工程师

主要负责公司客户网络安全、网络故障分析锁定影响范围,并给出解决方案。日常工作中经常会有大量csv 文件需要统计,文件处理工作主要依靠脚本完成。在工作中分别使用python 和go设计开发了几款脚本。

2018-10-01 -2019-10-01北京巨宝科技有限公司运维工程师

1.负责网站平台的更新升级和对用户使用的问题进行解决,协助分析系统bug跟踪处理进度; 负责服务器日常维护,负责搭建及维护监控平台,编写并及时更新工作手册; 2.登录服务器检查Mysql、Nginx、Php、Redis等 运行情况; 3.每日检查Mysql、Redis、程序代码 等 备份及Linux系统资源运行状况; 4.负责系统平台上线及更新并进行系统新功能的测试,并编写测试报告运维报告相关文档; 5.编写常用脚本提高运维的准确和效率,如Mysql、Radis、程序代码 备份脚本; 5.管理和维护 Nginx、Php、Mysql、Radis、Python采集 等服务及程序; 6.定期到机房对设备进行健康检查;

教育经历

2013-10-01 - 2015-10-01北京八维研修学院信息安全专科

主要学习方向是Linux系统运维,在校期间学习了一点python 编程。

技能

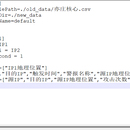

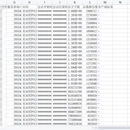

统计指定的csv文件中的某列出现次数,同时将文件中其他需要的列进行取出。由于不能确定csv文件中需要统计和取出的列所以采用配置文件的方式进行配置,以实现高可用和兼容性。

为实现高可用性减少依赖包的使用,所以采用python自带的os和re对原始文件内容进行处理。脚本整体功能主要是从系统导出csv文件中获取服务器IP与服务端口两列数据,并对服务器IP列进行去重,服务器端口列采用未出现过便增加的方式。最终实现将服务器IP和对应的服务器端口输出到新文件中。

通过上图搭建可能会发现一个问题,也就是备份机2为什么不直接从源获取备份文件,我就和大家说说为什么要这么做,主要因为源服务器是线上服务器而备份机2是房子在公司的一台服务器。源服务器打包压缩文件会需要很长时间完事以后还要向备份机1传输备份文件,源打包压缩是从 凌晨2点开始直到传输到备份1完毕 需要四个小时左右,也就是到了早上六点,既然到了早上六点可能就会有用户访问网站了那么就要保正源服务器只为用户处理请求。所以备份机2就不能再去向源请求备份文件了。至于备份机2什么时间段向备份机1去请求数据就根据公司的上班时间安排吧,最好错开上班时间,因为下载数据会占用很大网络带宽。